| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

- 데이터분석

- 주피터노트북 커널 제거

- ubuntu

- random forest

- Python

- 회귀분석

- 딥러닝

- 모두를 위한 딥러닝

- deep learning

- pandas

- jupytertheme

- 주피터노트북

- Linear Regression

- 한빛미디어

- overfitting

- lol api

- 주피터테마

- 나는리뷰어다2021

- Machine Learning

- 경사하강법

- deeplearning

- GitHub

- MySQL

- 주피터 노트북 테마

- Git

- 주피터노트북 커널 추가

- Udacity

- 주피터노트북 커널 목록

- regression

- feature scaling

- Today

- Total

유승훈

친절한 딥러닝 수학(2) - 순전파를 배우자 본문

본 도서는 한빛미디어 도서 서평단 <나는 리뷰어다 2021>로 선정되어 받은 도서입니다. 리뷰 작성 겸 각 챕터를 간단하게 정리해보고자 합니다.

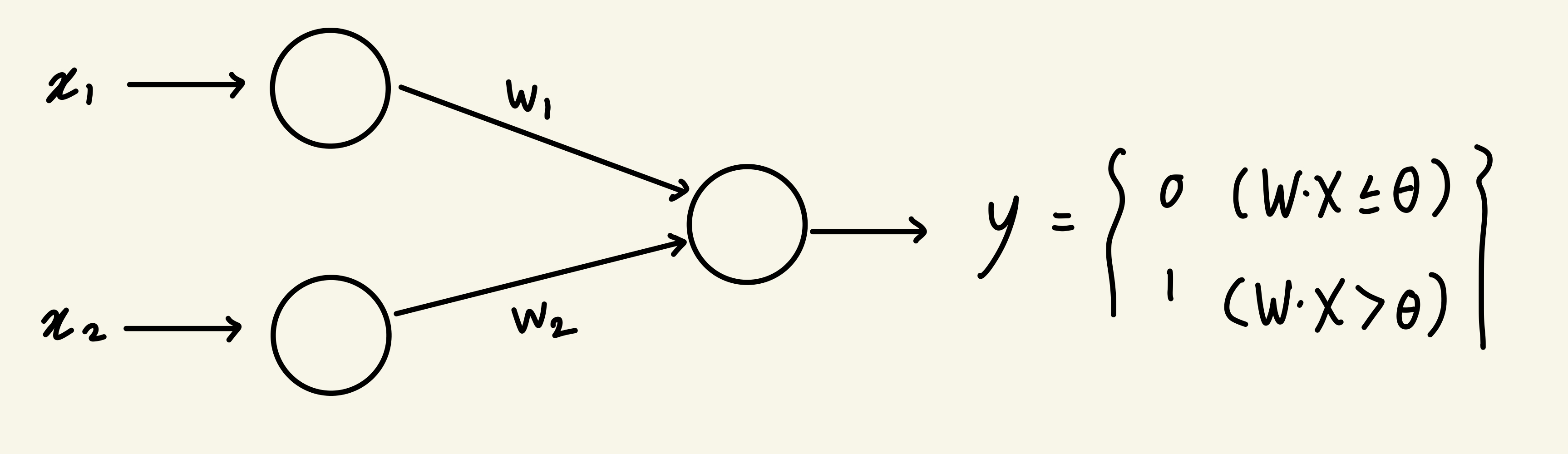

신경망의 가장 기초가 되는 것은 퍼셉트론입니다. 아주 단순한 문제를 풀 수 있는 알고리즘입니다.

여기서 $-\theta=b$로 하고 정리하면,

b는 퍼셉트론이 어느 정도 1을 출력하기 쉬운가 하는 경향을 조절한다고 할 수 있습니다.

b=0일 때는 $WX$가 0보다 크기면 하면 1이지만, b=100이면 $WX$가 -100보다 크기면 하면 1이 됩니다. b의 값에 따라 1이 되는 값의 범위가 상대적으로 차이가 나는 것을 알 수 있습니다.

여기서 W는 가중치, b는 편향이라고 합니다.

퍼셉트론으로 이미지의 세로가 길지 가로가 길지를 분류한다고 해 봅시다. 가중치를 통해 가로-세로 값을 계산해주고, 결과값이 음수임을 통해 세로가 더 길다고 판단합니다.

이런 퍼셉트론은 선형분리 가능한 문제를 풀 수 있지만, 불가능한 문제를 풀지는 못합니다. 위와 같이 가로가 긴지 세로가 긴지가 아니라 이미지가 정사각형인지 아닌지를 분류하는 문제가 있다고 합시다.

And나 Or 문제는 선형분리가 가능하지만, XOR(배타적 논리합)같은 문제는 선형분리가 불가능합니다. 선형분리를 한다고 하더라도 정확도가 굉장히 낮은 결과를 보입니다. 이러한 문제를 선을 여러개 그어서 푸는 방법이 제안되었지만, 가중치나 편향을 효율적으로 학습시킬 방법을 찾지 못해서 당시에는 그냥 못푸는 문제로 생각했다고 합니다.

lec08 - Basic Deep Learning

이번 강의에서는 딥러닝, 머신러닝에 대한 설명이나 활용보다는 역사가 어떻게 흐르면서 발전했는지를 설명합니다. 인류가 기계에 있어 궁극적으로 삼는 목표는, 사람을 대신해서 귀찮은 일을

seunghuni96.tistory.com

조금 더 자세한 내용은 모두를 위한 딥러닝 강의를 듣고 정리한 위 글에 나와 있습니다.

여러개의 선을 긋는다는 것은 위와 같이 유닛을 겹쳐서 여러 층을 만들어주는 것입니다. 처음 소개했던 형태의 퍼셉트론을 단층 퍼셉트론, 위와 같은 여러 층의 퍼셉트론을 다층 퍼셉트론이라고 합니다.

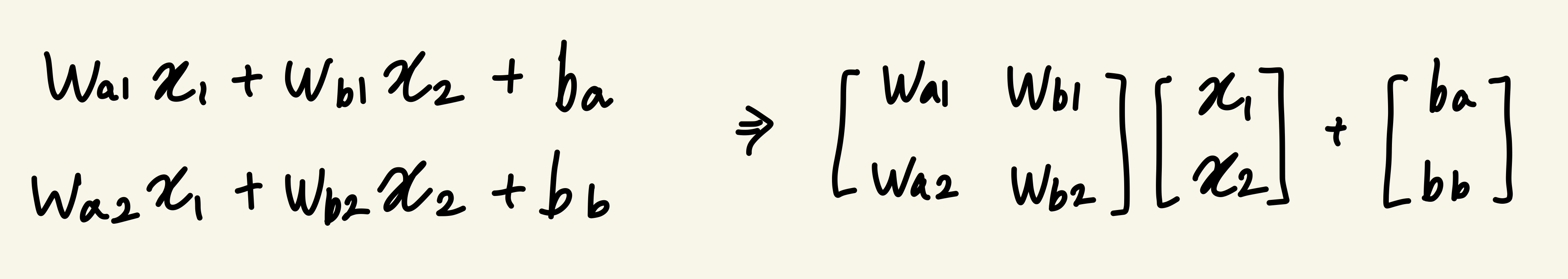

은닉층까지만 고려하면 이런 형태로 식이 정리됩니다.

활성화 함수는 노드에 들어온 값을 다음 단계로 넘어가도록 할지, 말지를 결정하는 역할을 합니다. $Wx+b$가 0 이하면 0, 1보다 크면 1을 Return하는 것도 계단 함수라고 하는 활성화 함수입니다. 하지만 미분이 어렵다는 단점 때문에 실제로 쓰이지는 않습니다. 이외에도 Sigmoid, Tanh, Relu 같은 다양한 활성화 함수들이 활용되고 있습니다.

Activation Function을 a라고 하고 출력층까지의 식을 최종적으로 정리하면,

이렇게 정리할 수 있습니다.

활성화 함수는 왜 필요할까요? 활성화 함수는 유닛에 들어간 입력값이 출력값으로 나올 때, 출력값이 Linear하지 않게 나오도록 하는 역할을 합니다. 다층 퍼셉트론을 단순히 여러개 쌓는 것이 아니라, 활성화 함수를 거친 비선형 시스템이 만들어지도록 합니다.

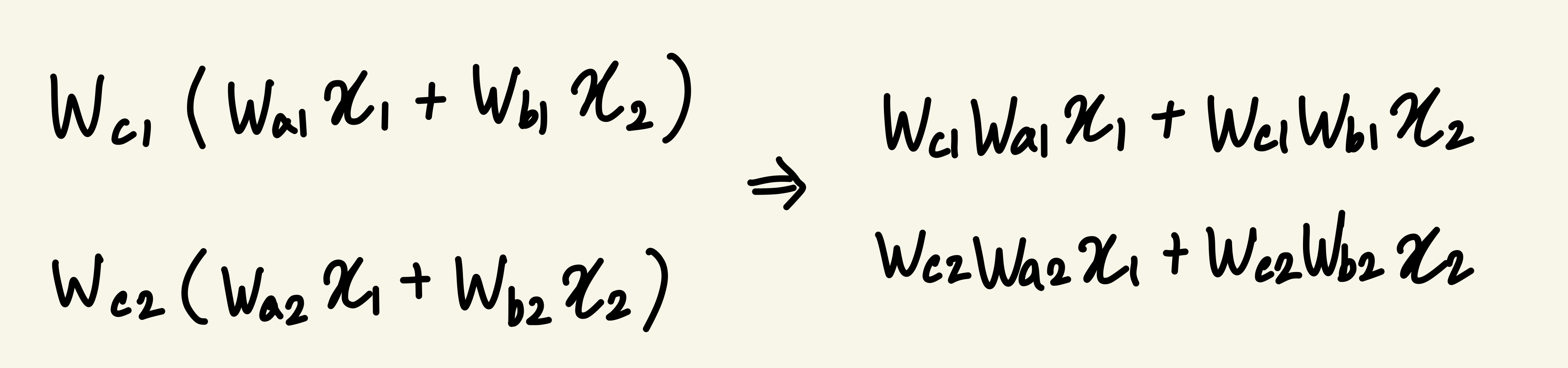

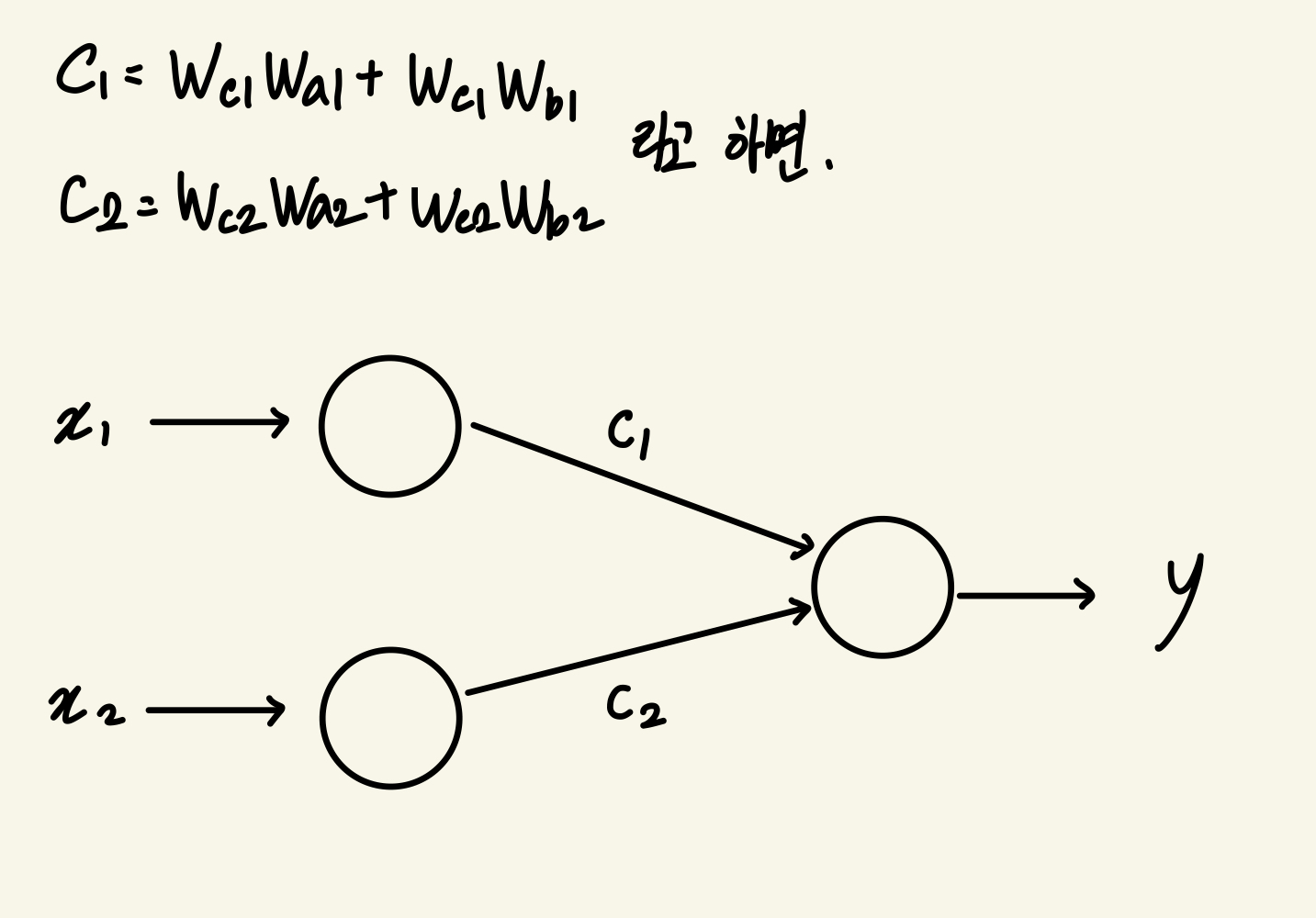

그렇다면 활성화 함수가 없다고 가정해봅시다. 활성화 함수가 없고, b=0으로 설정하면,

위와 같이 활성화 함수가 없이는 다층 퍼셉트론이라도 단층 퍼셉트론과 같은 형태로 정리됩니다.

'책 리뷰 > 친절한 딥러닝 수학' 카테고리의 다른 글

| 친절한 딥러닝 수학(3) - 역전파를 배우자 (0) | 2021.04.16 |

|---|---|

| 친절한 딥러닝 수학(1) - 신경망을 시작하자 (0) | 2021.03.31 |